Time-of-Flight versus Stereovision – wer punktet wo?

Die 3D-Bildverarbeitung gewährt Anwendern des maschinellen Sehens im Vergleich zu 2D zusätzliche Einblicke. Durch die dritte Dimension profitieren daher zahlreiche Branchen von weiteren Vision Technologien und Anwendungen, allen voran die Fabrikautomation, Robotik und Logistik sowie Medizin. Dort haben sich besonders zwei 3D-Methoden etabliert: Time-of-Flight (ToF) und Stereovision, die hier näher betrachtet und miteinander verglichen werden.

Anwendungen von Time-of-Flight-Kameras

In unserem White Paper beantworten wir folgende Fragen:

Worin unterscheiden sich die einzelnen 3D-Technologien?

Wie genau funktioniert das Time-of-Flight-Verfahren?

Wie können ToF-Kameras in Logistik, Robotik und Medizin eingesetzt werden?

3D Vision für die räumliche Dimension

Bei der 2D-Bildverarbeitung ist das aufgenommene Bild zwangsweise immer eine zweidimensionale Projektion eines dreidimensionalen Objektes. Tiefeninformationen lassen sich mit einer 2D-Kamera nicht erfassen. Je nach Blickwinkel kann sich somit eine andere Kontur eines dreidimensionalen Objekts im Bild ergeben. Für viele zweidimensionale Anwendungen sind diese Form- und Tiefeninformationen jedoch nicht relevant. Häufiger wird die 2D-Bildgebung für Struktur- und Farbanalysen, Bauteil-Identifizierungen, Anwesenheits-Kontrollen, Schadens- oder Anomalie-Detektionen sowie für die Zeichen-Erkennung und Maßhaltigkeits-Prüfung eingesetzt. Voraussetzung für diese Aufgaben ist eine optimale Beleuchtung, die einen ausreichenden Kontrast im Bild erzeugt.

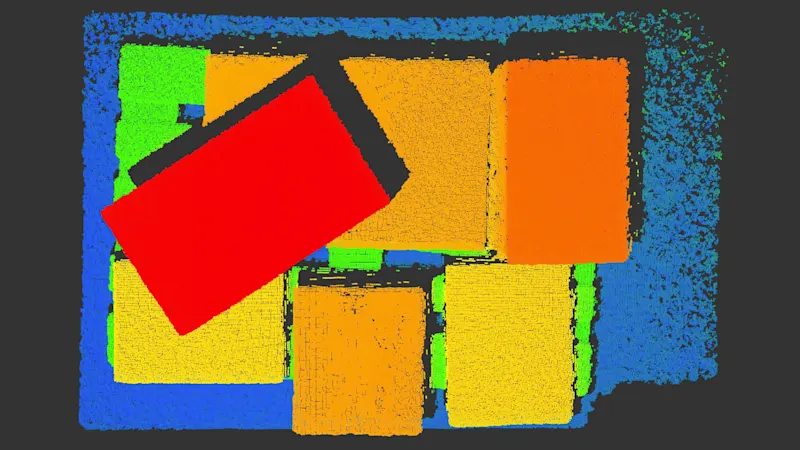

Bei 3D-Bildaufnahmen hingegen steht zusätzlich die Höheninformation einer Szene zur Verfügung. Somit lassen sich Volumen, Formen, Entfernungen, Positionen im Raum und Objektorientierungen bestimmen oder eine räumlich abhängige Anwesenheitskontrolle von Gegenständen durchführen. Aber auch für 3D-Bildgebung gibt es, je nach Technologie, Voraussetzungen wie etwa Lichtverhältnisse oder Oberflächenbeschaffenheit, die für eine optimale Bildaufnahme berücksichtigt werden müssen. Daneben gibt es Anwendungen, für die beide Technologien in Frage kommen. Hierbei sind immer die jeweiligen Vor- und Nachteile abzuwägen.

2D versus 3D Vision Technologie

Anforderungen an die Aufgabe | 2D | 3D |

|---|---|---|

Analyse von Volumen und/oder Formen | + | - |

Struktur und Farbe müssen erkannt werden | + | - |

Gute Kontrastinformationen vorhanden | + | - |

Kontrastinformationen sind schlecht oder nicht vorhanden | - | + |

Höhenunterschiede müssen erkannt werden | - | + |

Positionierungsaufgabe/Detektion in der dritten Dimension | - | + |

Barcode- und Zeichenerkennung | + | - |

Bauteilidentifizierung | + | + |

Anwesenheitskontrolle von Bauteilen | + | + |

Schadensdetektion | + | + |

3D-Technologien im Überblick

Mit welchen Eigenschaften punkten Time-of-Flight und Stereovision, was sind ihre Besonderheiten und wo liegen ihre Stärken bzw. Schwächen?

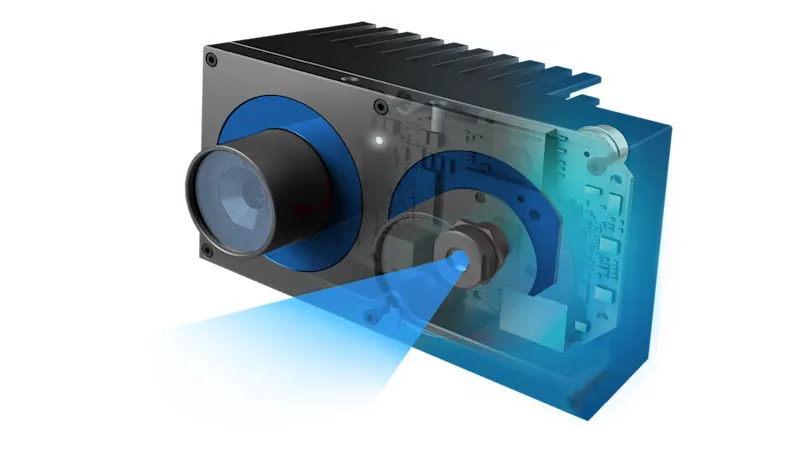

Time-of-Flight

Time-of-Flight ist eine sehr effiziente Technologie, Entfernungen zu messen, um Tiefendaten zu gewinnen. Hierzu sendet eine in die Kamera integrierte Lichtquelle Lichtpulse aus, welche auf das Objekt treffen. Dieses reflektiert die Lichtpulse zurück zur Kamera. Aus der dafür benötigten Zeit lässt sich die Entfernung und somit der Tiefenwert für jeden einzelnen Pixel bestimmen. Als Ergebnis werden für das inspizierte Objekt die 3D-Werte als räumliches Bild in Form einer Tiefenkarte oder Punktwolke ausgegeben. Das ToF-Verfahren liefert außerdem ein 2D-Intensitätsbild in Form von Grauwerten für jeden Pixel und ein Konfidenzbild, welches das Maß an Vertrauen in die einzelnen Werte abbildet.

Für die 3D-Aufnahme benötigt ToF weder Kontrast noch spezifische Merkmale wie Ecken und Kanten. Die Aufnahme ist außerdem nahezu unabhängig von der Intensität und Farbe des Objekts durchführbar, sodass sich dieses leicht mittels Bildverarbeitung vom Hintergrund trennen lässt. Das Verfahren funktioniert auch bei sich bewegenden Objekten und kann bis zu neun Millionen millimetergenaue Entfernungs-Messungen pro Sekunde durchführen. Verglichen mit anderen 3D-Kameras sind ToF-Kameras kostengünstiger, sehr kompakt und weniger komplex. Dies ermöglicht eine einfache Installation und Integration.

Die Kamera liefert beste Ergebnisse jedoch nur unter bestimmten Umgebungs-Bedingungen und für einen definierten Messbereich. Bedingt durch das zugrunde liegende Lichtlaufzeit-Messverfahren führen bei der ToF-Methode mehrfache Reflexionen des ausgesendeten Lichts etwa durch Ecken oder eine konkave Form des Messobjekts zu Abweichungen in den Messergebnissen. Stark reflektierende, zu nah an der Kamera befindliche Oberflächen können zu Streulicht in der Linse führen, woraus Artefakte entstehen. Bei sehr dunklen Oberflächen besteht die Gefahr, dass zu wenig Licht für eine robuste Messung reflektiert wird. Ein zu kleiner Arbeitsabstand kann das Verfahren ebenso beschränken, womit sich ToF insgesamt für eine mittlere Mess- bzw. Tiefengenauigkeit eignet.

Stereovision

Stereovision funktioniert ähnlich wie das menschliche Augenpaar. Das 3D-Prinzip beruht darauf, dass die Tiefeninformationen mittels synchroner Aufnahmen zweier 2D-Kameras aus unterschiedlichen Blickwinkeln gewonnen werden. Für die Berechnung der 3D-Daten muss die Position der beiden Kameras untereinander (extrinsische Parameter) bekannt sein. Darüber hinaus bedarf es auch der Information über die intrinsischen Parameter jeder einzelnen Kamera, wie etwa optisches Zentrum und Brennweite des Objektivs. Zusammen ergeben sich daraus kameraspezifische Kalibrierwerte. Für die Berechnung der Tiefeninformationen werden die beiden 2D-Bilder zunächst rektifiziert. Danach sucht ein Matching-Algorithmus die korrespondierenden Pixel im rechten und linken Bild. Mit Hilfe der Kalibrierwerte lässt sich ein Tiefenbild der Szene bzw. des Objekts als Punktwolke generieren. In welchem Arbeitsabstand dieses Verfahren funktioniert hängt vom Abstand und Anstellwinkel der beiden Kameras ab und variiert daher.

Das Verfahren kommt prinzipiell im Vergleich zu ToF ohne aktive Beleuchtungs-Einheit wie Licht- oder Laserstrahlen aus, benötigt jedoch immer ein Mindestmaß an Umgebungslicht, da es sich hier technisch gesehen um zwei separate 2D-Kameras handelt. Sind die Bedingungen für andere 3D-Verfahren mit aktiver Beleuchtungs-Einheit schwierig, führt Stereovision zu besseren Ergebnissen, wie etwa bei hellem Umgebungslicht, überlappenden Messbereichen und reflektierenden Oberflächen.

Bei Flächen mit wenig Struktur findet das Stereovision-Verfahren zu wenige korrespondierende Merkmale in beiden Bildern, um daraus dreidimensionale Informationen zu errechnen. Diese Einschränkungen lassen sich durch künstlich erzeugte Oberflächenstrukturen mittels Licht überwinden. Hierzu kann zusätzlich ein Lichtprojektor, der ein Zufallsmuster projiziert, integriert werden.

Strukturiertes Licht

Hierbei wird im Gegensatz zu Stereovision eine der Kameras durch einen Streifenlichtprojektor ersetzt. Dieser projiziert verschiedene Streifenmuster mit sinusförmigem Intensitätsverlauf und erzeugt somit eine künstliche, jedoch dem System bekannte Struktur auf der Oberfläche. Die Verzerrung der projizierten Streifen auf der Oberfläche wird zur Berechnung der 3D-Informationen genutzt und führt zu genaueren Messergebnissen.

Sensoren mit strukturiertem Licht erzielen besonders hohe Genauigkeit im Nahbereich. Der Einsatz strukturierten Lichts erzeugt eine hohe Rechenlast und ist für bewegte Objekte ungeeignet, da mehrere Bilder nacheinander aufgenommen und verarbeitet werden. Daher eignet sich dieses Verfahren für Echtzeit-Anwendungen nur bedingt oder unter Inkaufnahme höherer Kosten.

Vor- und Nachteile

Time-of-Flight | Stereovision | Strukturiertes Licht | |

|---|---|---|---|

Reichweite | + | o | o |

Genauigkeit | o | + | + |

Low-Light Performance | + | o | + |

Bright-Light Performance | + | + | - |

Homogene Oberflächen | + | - | + |

Bewegte Objekte | o | + | - |

Kameragröße | + | o | - |

Kosten | + | o | - |

Welche Anwendungen profitieren

Typische Anwendungen Time-of-Flight

Time-of-Flight spielt seine Trümpfe besonders in Anwendungen aus, in denen ein großer Arbeitsabstand gepaart mit einem großen Messbereich und hoher Geschwindigkeit sowie geringer Systemkomplexität gefragt sind, während äußerste Genauigkeit weniger relevant ist.

(Volumen, Form, Position, Ausrichtung)

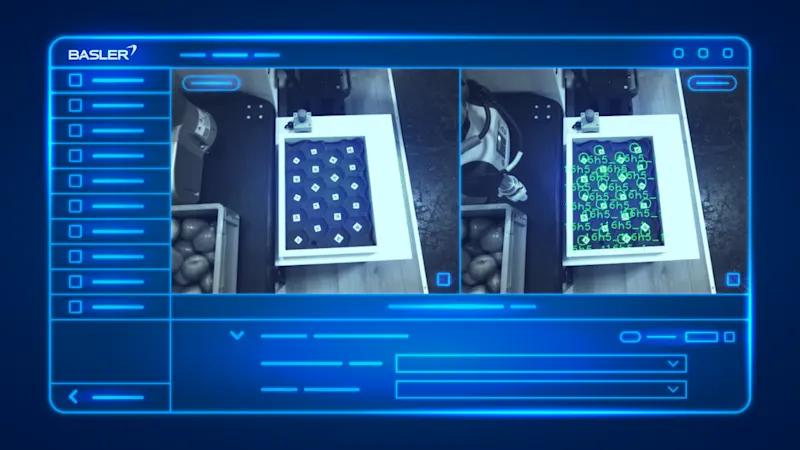

Fabrikautomation: Objekte finden, greifen, montieren; beschädigte Objekte oder Stapelfehler detektieren

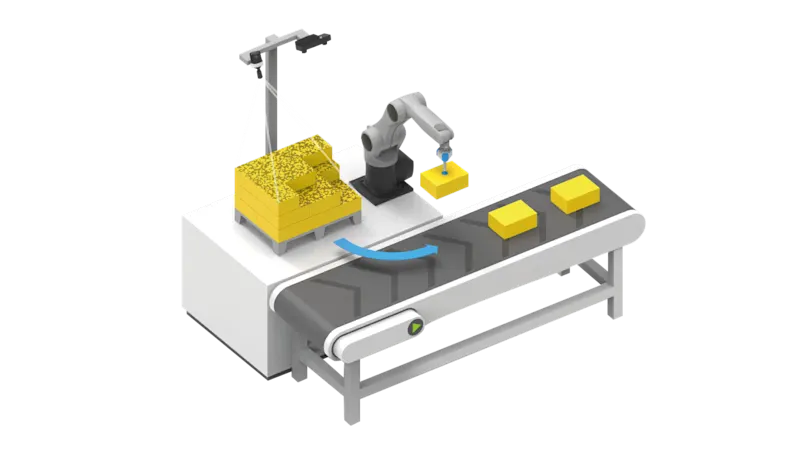

Robotik: Greifpunkte für Roboter bestimmen; Greifaufgaben an Förderbändern, Bin-Picking, Pick-and-Place

Logistik: Verpacken; Stapeln, (De-)Palettieren; Etikettieren; autonom fahrende Fahrzeuge (Navigation, Sicherheits-Warnungen)

Medizin: Positionieren und Überwachen von Patienten

Typische Anwendungen Stereovision und strukturiertes Licht

Stereovision bietet bereits eine hohe Messgenauigkeit und wird von Sensoren mit strukturiertem Licht noch übertroffen. Diese Art von 3D-Sensoren eignen sich für Anwendungen, bei denen unkooperative Oberflächen mit wenig Struktur erfasst werden sollen oder eine sehr hohe Messgenauigkeit erzielt werden soll.

Bestimmung von Lage und Orientierung

Hochgenaue Vermessung von Objekten (Volumen, Form, Position, Ausrichtung)

Robotik: Bin-Picking, Navigation, Kollisionsvermeidung, Hol- und Bringdienste

Logistik: Indoor-Navigation von Fahrzeugen, Be- und Entladen von Maschinen, (De-)Palettieren

Outdoor: Vermessen und Inspizieren von Baumstämmen

Bauteilprüfung, z.B. Schadensdetektion

Aktuell steigt in vielen Anwendungen der Bedarf nach 3D-Technologie, die mit künstlicher Intelligenz wie Deep Learning kombiniert wird. Dieses Zusammenspiel vereinfacht die Objekterkennung und genaue Positions-Bestimmung von Objekten im Raum. Roboter sind dadurch in der Lage, Objekte zu greifen, die sie nie zuvor gesehen haben. Anhand von SLAM-Systemen (simultaneous localization and mapping) lassen sich mithilfe von Vision Sensoren hochaufgelöste, dreidimensionale Karten erstellen, die in autonomen Fahrzeugen und Augmented Reality-Anwendungen verwendet werden.

Unsere 3D-Produkte

Finden Sie hier die passende Hard- und Software für Ihr 3D-Vision System