Deep Learning Vision Systeme für die industrielle Bildverarbeitung

Systemaufbau und Komponenten

Deep Learning Vision Systeme sind häufig bereits ein zentraler Bestandteil der industriellen Bildverarbeitung. Sie ermöglichen präzise Fehlererkennung, intelligente Qualitätskontrolle und automatisierte Entscheidungen – überall dort, wo klassische Bildverarbeitungsmethoden an ihre Grenzen stoßen. Wir zeigen, wie ein funktionsfähiges Deep Learning Vision System aufgebaut ist und welche Komponenten für einen zuverlässigen Betrieb erforderlich sind.

Letzte Aktualisierung: 02.12.2025

Die Systemstruktur von Deep Learning Vision Systemen

Deep Learning Vision Systeme sind von Grund auf auf neuronale Netze ausgelegt. Sie setzen auf GPU-basierte Rechenleistung, optimierte Frameworks und End-to-End-Lernansätze. Das macht sie flexibel, aber oft auch ressourcenintensiv.

Das Ziel: Durchgängige KI-Integration von Bildaufnahme bis zur Entscheidung

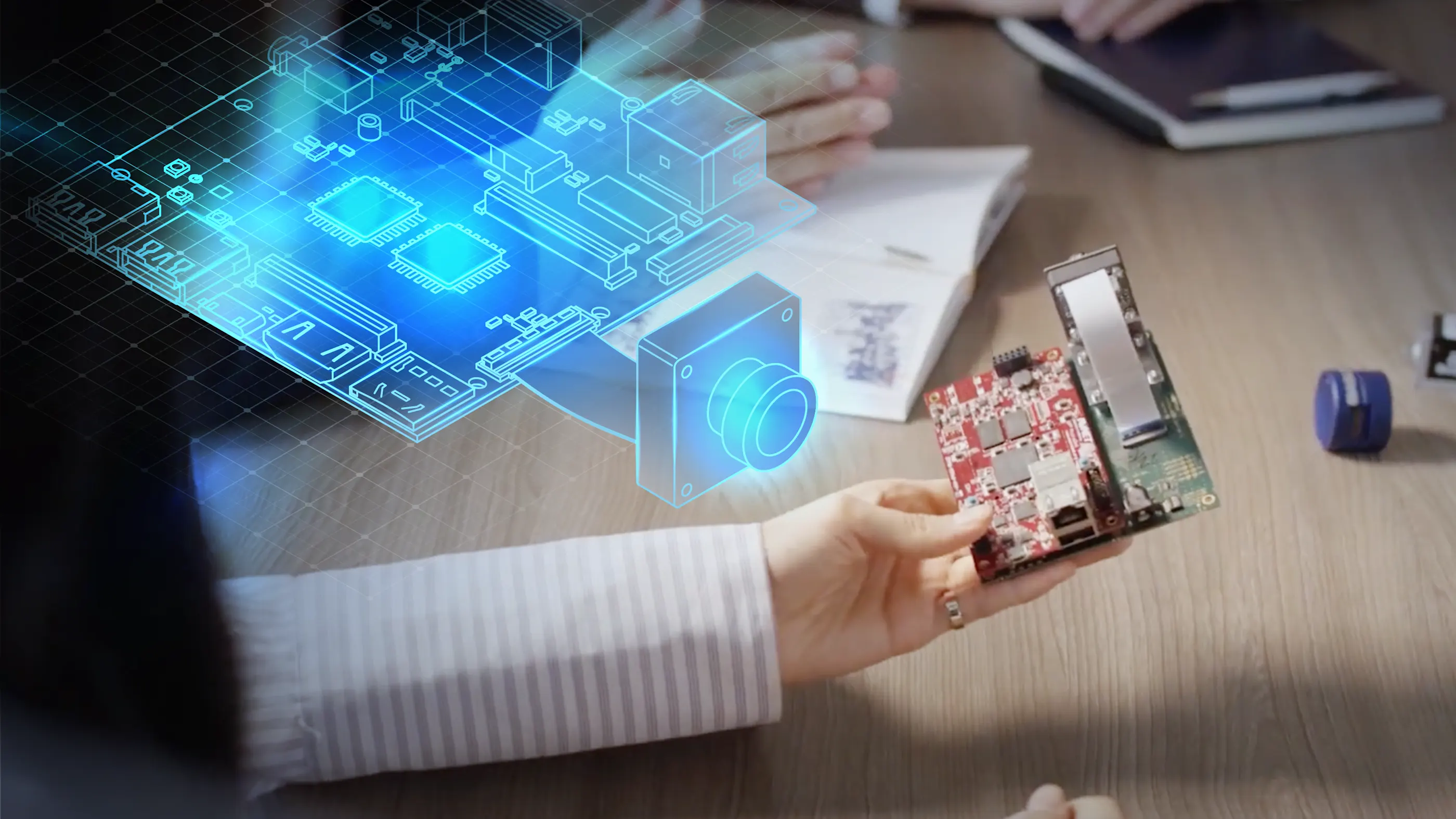

Das Hauptziel eines Deep Learning Vision Systems ist die nahtlose Integration von künstlicher Intelligenz über alle Prozessschritte hinweg. Vom

Erfassen der Rohdaten durch die Kamera über die

Echtzeitverarbeitung der Bilddaten bis hin zur

automatisierten Entscheidungsfindung durch das KI-Modell

sind alle Komponenten auf Deep Learning optimiert. So entsteht ein geschlossenes System, das präzise, reproduzierbare und skalierbare Ergebnisse für anspruchsvolle industrielle Anwendungen liefert.

Deep Learning Vision Pipeline: von der Bildaufnahme zur KI-gestützten Entscheidung

Das Zusammenspiel der Systemkomponenten ist entscheidend für die Leistungsfähigkeit eines Deep Learning Vision Systems. Der typische Workflow in einem Deep Learning Vision System erfolgt in diesen aufeinander folgenden Prozessschritten:

1. Bildaufnahme: Die Machine Vision Kamera erfasst das Rohbild und liefert hochwertige Bilddaten.

2. Bildübertragung: Ein Framegrabber leitet die Bilddaten effizient und verlustfrei an die Verarbeitungs-Hardware weiter.

3. Vorverarbeitung: Die pylon Software oder interne Kamerafunktionen optimieren das Bild (z. B. Rauschreduzierung oder Debayering). Die Deep Learning Software übernimmt die Steuerung, Konfiguration und Analyse der Daten mittels KI-Modellen.

4. KI-Inferenz: Das CNN-Modell analysiert das Bild und trifft eine Entscheidung (z. B. Fehlererkennung).

5. Ergebnisübertragung: Die Ergebnisse werden an die Steuerung oder das übergeordnete System weitergeleitet.

Schnittstellen und Integrationslösungen sorgen für eine reibungslose Kommunikation zwischen den Modulen und ermöglichen die Einbindung in bestehende Produktionsumgebungen. Dieser Ablauf gewährleistet eine schnelle, zuverlässige und reproduzierbare Bildanalyse in industriellen Anwendungen.

Die Hardware- und Software-Komponenten eines Deep Learning Vision Systems

Ein Deep Learning Vision System besteht aus mehreren technisch aufeinander abgestimmten Komponenten. Jede Komponente übernimmt eine spezifische Aufgabe innerhalb des Gesamtsystems und trägt zur Leistungsfähigkeit und Zuverlässigkeit bei.

Deep Learning Vision Hardware

Die Bildverarbeitungs-Hardware ist das Rechenzentrum des Deep Learning Vision Systems. Die Auswahl der Hardware richtet sich nach den Anforderungen an Verarbeitungsgeschwindigkeit, Systemkosten und Skalierbarkeit. Je nach Anwendung kommen verschiedene Plattformen zum Einsatz:

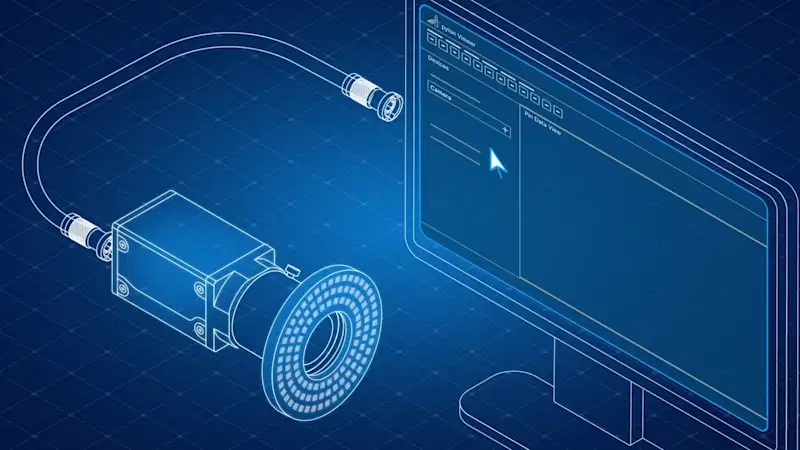

Machine Vision Kamera

Die Machine Vision Kamera ist das Herzstück des Systems. Sie erfasst die Bilddaten, die später vom KI-Modell verarbeitet werden. Eine hohe Bildqualität ist entscheidend für präzise Inferenz-Ergebnisse. Industriekameras wie die Basler ace, Basler ace 2, Basler dart oder Basler racer Serien bieten:

Hohe Auflösung und Bildqualität

Unterstützung gängiger Schnittstellen wie GigE, USB 3.0 und CoaXPress

Interne Bildvorverarbeitung (z. B. De-Bayering, Schärfen, Rauschreduzierung)

Reproduzierbare Ergebnisse für zuverlässige Deep Learning-Anwendungen

Framegrabber und Bilddatenmanagement

Für Anwendungen mit hohem Datendurchsatz oder Echtzeit-Anforderungen ist ein Framegrabber unverzichtbar. Framegrabber erfassen die Bilddaten direkt von der Kamera und leiten sie zur weiteren Verarbeitung an das System weiter. Besonders in Kombination mit FPGA-Prozessoren ermöglichen sie latenzfreie, robuste Highspeed-Bilderfassung und -verarbeitung.

Deep Learning Software und Tools

Die Software bildet das Bindeglied zwischen Hardware und KI-Modell. Sie ermöglicht die Integration, Konfiguration und Steuerung der Kameras sowie das Training und die Ausführung von Deep Learning-Modellen.

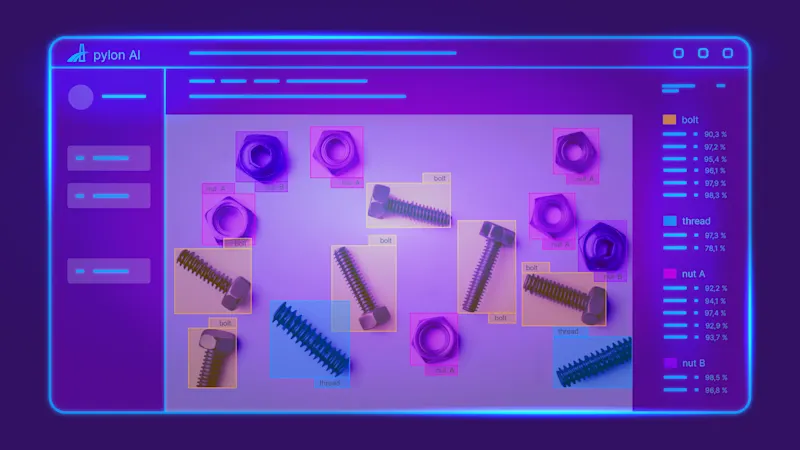

pylon AI für Bildanalyse

Mit pylon AI steht eine leistungsstarke Plattform zur Verfügung, die speziell für die effiziente Integration und Ausführung von Convolutional Neural Networks (CNNs) in industriellen Bildverarbeitungsprozessen entwickelt wurde. pylon AI ermöglicht die einfache Einbindung, Optimierung und das Benchmarking eigener KI-Modelle direkt auf der Zielhardware.

pylon vTools für Bildverarbeitung

Die Kombination mit den pylon vTools bietet sofort einsatzbereite, anwendungsspezifische Bildverarbeitungsfunktionen wie Objekterkennung, OCR, Segmentierung und Klassifizierung – ohne tiefgreifende Programmierkenntnisse. Die vTools basieren auf klassischen Algorithmen und auf künstlicher Intelligenz.

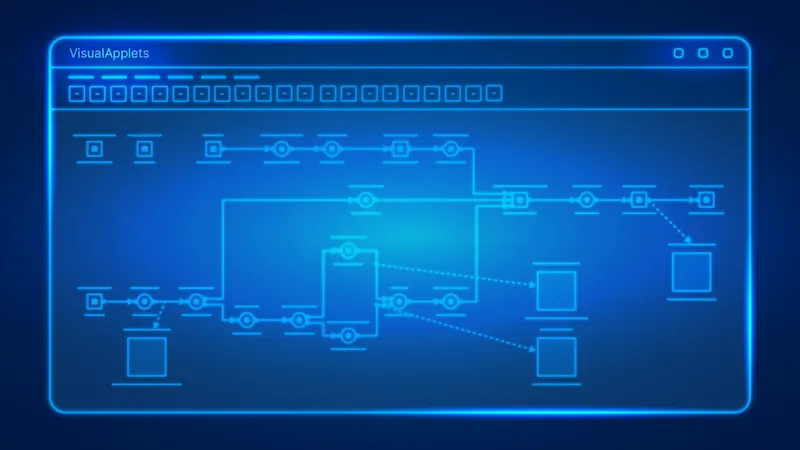

VisualApplets für FPGA-Programmierung

Für FPGA-basierte Systeme bietet VisualApplets eine intuitive, grafische Entwicklungsumgebung, mit der sich Bildvorverarbeitungsschritte flexibel auf Hardwareebene realisieren lassen. Diese Kombination sorgt für maximale Flexibilität, Skalierbarkeit und Präzision im gesamten Deep Learning Vision System. Durch FPGA-basiertes Pre-processing lassen sich zum Beispiel große Datenmengen bereits vor der eigentlichen Inferenz gezielt reduzieren und aufbereiten, indem nur die relevanten Bildbereiche (Region of Interest, ROI) für die weitere Verarbeitung ausgewählt werden.

Vorteile: reduzierte Rechenlast, höherer Inferenz-Durchsatz bei gleicher Hardware und erhöhte Genauigkeit durch Reduzierung aufs Wesentliche.

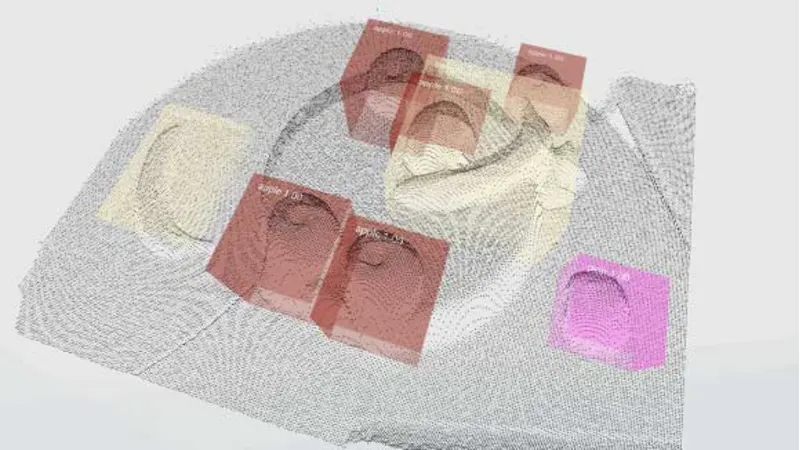

Inferenz durch das KI-Modell

Während der Inferenzphase übernimmt in der Regel ein CNN (Convolutional Neural Network) die Analyse der eingehenden Bilddaten. Das Modell verarbeitet die von der Machine Vision Kamera aufgenommenen Bilder in mehreren, aufeinanderfolgenden Schichten, um relevante Merkmale wie Formen, Kanten oder Texturen zu extrahieren. Anschließend erfolgt die Klassifizierung, Segmentierung oder Objekterkennung – je nach Aufgabenstellung.

Mit pylon AI und den pylon vTools geschieht dieser Prozess automatisiert und in Echtzeit: Die Bilddaten werden direkt an das KI-Modell übergeben, das dann beispielsweise fehlerhafte Bauteile identifiziert, Text auf Produkten liest (OCR) oder spezifische Objekte im Bild lokalisiert.

Die Ergebnisse der Inferenz stehen unmittelbar für nachgelagerte Prozesse wie Sortierung, Qualitätskontrolle oder Prozessoptimierung zur Verfügung. Die nahtlose Integration in das Deep Learning Vision System gewährleistet eine schnelle, präzise und reproduzierbare Entscheidungsfindung.

Die Qualität des Modells hängt maßgeblich von der Güte der Trainingsdaten und der Optimierung für die eingesetzte Hardware ab. Eine möglichst hohe Bildqualität ist also nicht nur im Prozessschritt der Bildaufnahme wichtig - sie bildet die Basis für das Training der KI. Je hochwertiger diese Bilddaten im Training sind, desto präziser und zuverlässiger werden die Ergebnisse der KI-Analysen und die daraus abgeleiteten Entscheidungen.

Bereits vortrainierte Modelle lassen sich mit pylon AI einfach integrieren und weiterentwickeln.

Systemintegration und Schnittstellen

Entscheidend für die Performance von Deep Learning Vision Systemen

Die erfolgreiche Implementierung von Deep Learning Vision Systemen in der industriellen Bildverarbeitung hängt maßgeblich von einer durchdachten Systemintegration und der Wahl der richtigen Schnittstellen ab. Eine effiziente Kommunikation zwischen KI-Modell und Hardware sowie eine reibungslose Einbindung in den Produktionsablauf sind hierbei von zentraler Bedeutung.

Nahtlose Hardware-Software-Kommunikation

Die pylon Software stellt zertifizierte Treiber und leistungsfähige Schnittstellen bereit, die eine direkte und zuverlässige Kommunikation zwischen der KI-Inferenz und der Kamera-Hardware sicherstellen. Dazu gehören Standards wie GigE Vision für flexible Netzwerklösungen, USB3 Vision für unkomplizierte Anbindung und CoaXPress für Anwendungen mit höchsten Bandbreiten- und Echtzeitanforderungen. Diese standardisierten Schnittstellen minimieren den Integrationsaufwand und garantieren eine stabile Datenübertragung.

pylon AI bietet hier eine leistungsstarke Lösung, indem es die Integration von Convolutional Neural Networks (CNNs) direkt in die etablierte pylon Bildverarbeitungspipeline ermöglicht. Dies gewährleistet eine robuste und effiziente Datenverarbeitung.

Industrielle Konnektivität

Die Unterstützung von OPC UA ist essenziell für die Anbindung an übergeordnete Steuerungssysteme. Sie ermöglicht die direkte Übergabe von KI-Ergebnissen an SPS- oder MES-Systeme. Als plattform- und herstellerunabhängiger Standard gewährleistet OPC UA einen einfachen sowie standardisierten Datenaustausch zwischen Maschinen. Mit dem OPC UA vTool veröffentlichen Sie Ergebnisse der Bildverarbeitungspipeline direkt auf einem OPC UA Server für reibungslosen Datenaustausch.

Ein Recipe Code Generator kann zudem die schnelle Anpassung von KI-Modellen an wechselnde Produktvarianten erleichtern und somit die Flexibilität in der Produktion steigern. Detaillierte Informationen zum Recipe Code Generator im pylon Viewer finden Sie auch in der Basler Produktdokumentation.

Flexible Architekturen: Edge Computing und Cloud-Integration

Die Anforderungen an Deep Learning Vision Systeme variieren je nach Anwendungsfall stark. Das macht flexible Architekturen unerlässlich:

Edge Computing für dezentrale Anwendungen

Für latenzkritische, mobile oder dezentrale Anwendungen bietet die Embedded Vision Technologie die Möglichkeit, KI-Modelle direkt am Ort des Geschehens ("at the edge") auszuführen. Plattformen wie NVIDIA® Jetson™ ermöglichen den sofortigen Betrieb von KI-Modellen auf dem Gerät, was maximale Autonomie, minimale Latenzzeiten und eine reduzierte Abhängigkeit von Netzwerkverbindungen gewährleistet.

Cloud-Integration für Skalierbarkeit

Für Anwendungen, die große Datenmengen, verteiltes Training oder die zentrale Verwaltung vieler Systeme erfordern, unterstützen wir die Integration mit führenden Cloud-Plattformen wie Amazon Web Services (AWS), Microsoft Azure und Google Cloud Plattform. Dies bietet die notwendige Skalierbarkeit und Flexibilität für komplexe Deep Learning Workflows.

Diese standardisierte und flexible Systemintegration gewährleistet eine schnelle, zuverlässige und reproduzierbare Analyse der Bilddaten. Sie ermöglicht die Integration von Deep Learning Vision Systemen in verteilte Produktionsumgebungen, sodass KI-gestützte Analysen und Entscheidungen unmittelbar dort erfolgen, wo die Bilddaten entstehen. Dies ist entscheidend für effiziente Qualitätskontrollen, Fehlererkennung und Prozessoptimierungen in komplexen, standortübergreifenden Produktionsnetzwerken.

Eine unkomplizierte Installation und zuverlässige Systemintegration sind dabei essenziell für den langfristigen Erfolg und helfen dabei, komplexe Aufgaben effizient zu meistern.

Ein funktionsfähiges Deep Learning Vision System besteht zum Beispiel aus einer hochwertigen Machine Vision Kamera, einem leistungsfähigen Framegrabber, passender Bildverarbeitungs-Hardware, spezialisierter Deep Learning Software und einem optimierten KI-Modell. Zuverlässige, leistungsfähige Schnittstellen stellen einen reibungslosen Ablauf in der Systemintegration sicher. Mit unseren Produkten und Services bieten wir Vision Ingenieuren und allen, die sich mit KI-Lösungen für ihre Anwendung befassen, eine solide Basis für anspruchsvolle industrielle Bildverarbeitungsprojekte – von der Prototypentwicklung bis zur Serienproduktion.