Systèmes de vision en deep learning pour le traitement des images industrielles

Structure et composants du système

Les systèmes de vision en deep learning sont souvent déjà un élément central du traitement industriel de l'image. Ils permettent une détection précise des erreurs, un contrôle intelligent de la qualité et des décisions automatisées, là où les méthodes conventionnelles de traitement d'images atteignent leurs limites. Nous montrons comment un système de vision à apprentissage profond fonctionnel est structuré et quels sont les composants nécessaires à un fonctionnement fiable.

Dernière mise à jour : 02/12/2025

La structure des systèmes de vision par apprentissage profond

Les systèmes de vision en deep learning sont conçus dès le départ pour les réseaux neuronaux. Ils s'appuient sur la puissance de calcul des GPU, des cadres optimisés et des approches d'apprentissage de bout en bout. Ils sont donc flexibles, mais souvent gourmands en ressources.

L'objectif : l'intégration de l'IA de bout en bout, de l'acquisition d'images à la prise de décision

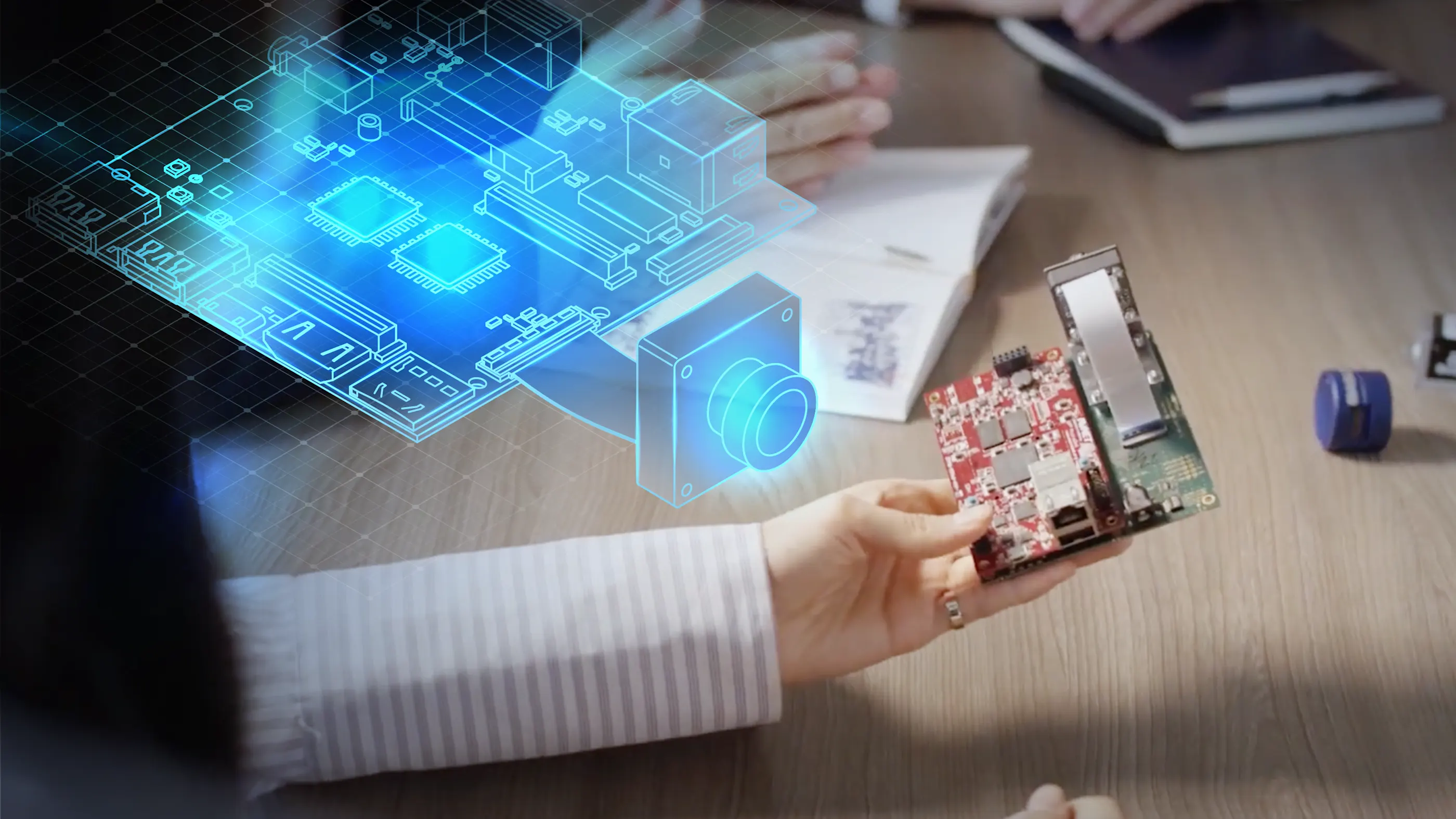

L'objectif principal d'un système de vision à apprentissage profond est l'intégration transparente de l'intelligence artificielle à toutes les étapes du processus. De la

la capture de données brutes par la caméra via le

traitement en temps réel des données d'image jusqu'à

la prise de décision automatisée grâce au modèle d'IA

tous les composants sont optimisés pour le deep learning. Cela crée un système fermé qui fournit des résultats précis, reproductibles et évolutifs pour les applications industrielles exigeantes.

Pipeline de la vision en deep learning : de l'acquisition d'images à la prise de décision assistée par l'IA

L'interaction des composants du système est cruciale pour la performance d'un système de vision en deep learning. Le flux de travail typique d'un système de vision par deep learning se déroule en plusieurs étapes successives :

1. Acquisition d'images : la caméra de vision industrielle capture l'image brute et fournit des données d'image de haute qualité.

2. Transmission d'images : Une carte d'acquisition transmet les données d'image efficacement et sans perte au matériel de traitement.

3. Prétraitement : le logiciel pylon ou les fonctions internes de la caméra optimisent l'image (par exemple, réduction du bruit ou débayérisation). Le logiciel de deep learning prend en charge le contrôle, la configuration et l'analyse des données à l'aide de modèles d'IA.

4. AI inference : le modèle CNN analyse l'image et prend une décision (par exemple, détection d'une erreur).

5. Transmission des résultats : les résultats sont transmis au contrôleur ou au système de niveau supérieur.

Les interfaces et les solutions d'intégration assurent une communication fluide entre les modules et permettent l'intégration dans des environnements de production existants. Ce processus garantit une analyse d'images rapide, fiable et reproductible dans les applications industrielles.

Les composants matériels et logiciels d'un système de vision par deep learning

Un système de vision en deep learning se compose de plusieurs éléments techniquement coordonnés. Chaque composant effectue une tâche spécifique au sein du système global et contribue à ses performances et à sa fiabilité.

Matériel de vision en deep learning

Le matériel de traitement d'images est le centre de données du système de vision en deep learning. Le choix du matériel dépend des exigences en termes de vitesse de traitement, de coûts du système et d'évolutivité. Différentes plateformes sont utilisées en fonction de l'application :

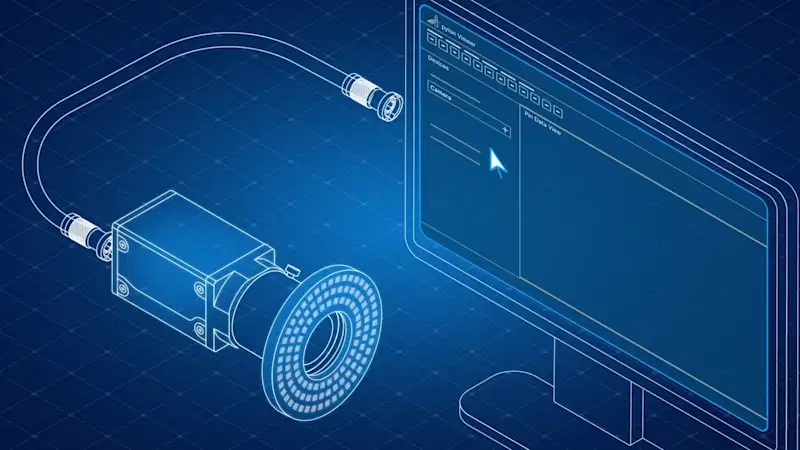

Caméras de vision industrielle

La caméra de vision industrielle est le cœur du système. Elle capture les données d'image qui sont ensuite traitées par le modèle d'IA. Les caméras industrielles telles que les séries Basler ace, Basler ace 2, Basler dart ou Basler racer offrent :

Haute résolution et qualité d'image

Prise en charge des interfaces courantes telles que GigE, USB 3.0 et CoaXPress

Prétraitement interne de l'image (par exemple, débayerisation, accentuation de la netteté, réduction du bruit)

Des résultats reproductibles pour des applications deep learning fiables

Carte d'acquisition et gestion des données d'image

Une carte d'acquisition est indispensable pour les applications exigeant un débit de données élevé ou des opérations en temps réel. Les cartes d'acquisition d'images capturent les données d'image directement à partir de la caméra et les transmettent au système pour un traitement ultérieur. Associées à des processeurs FPGA, elles permettent une acquisition et un traitement d'images à grande vitesse, robustes et sans latence.

Logiciels et outils de deep learning

Le logiciel constitue le lien entre le matériel et le modèle d'IA. Il permet l'intégration, la configuration et le contrôle des caméras ainsi que l'entraînement et l'exécution des modèles de deep learning.

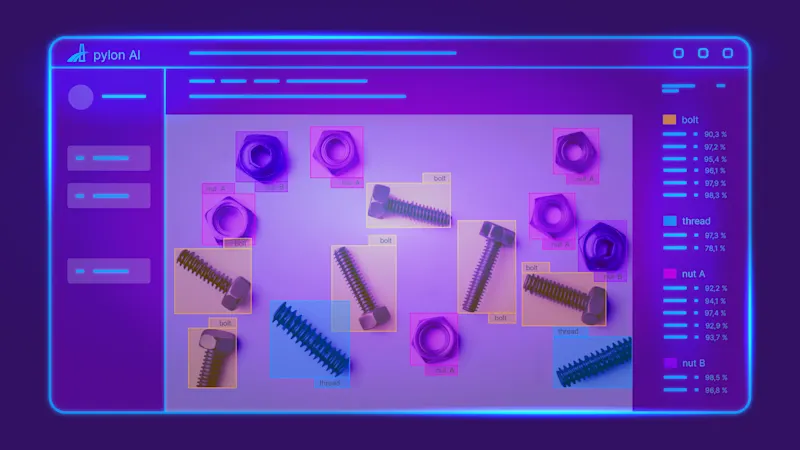

pylon AI

Avec pylon AI, une plateforme puissante est disponible qui a été spécialement développée pour l'intégration efficace et l'exécution de réseaux neuronaux convolutifs (CNNs) dans les flux de travail de traitement d'images industrielles. pylon AI permet l'intégration simple, l'optimisation et le benchmarking de vos propres modèles d'IA directement sur le matériel cible.

pylon vTools pour le traitement d'images

La combinaison avec les pylon vTools offre des fonctions de traitement d'images prêtes à l'emploi et spécifiques à l'application, telles que la reconnaissance d'objets, l'OCR, la segmentation et la classification - sans connaissances approfondies en matière de programmation. Les vTools sont basés sur des algorithmes classiques et sur l'intelligence artificielle.

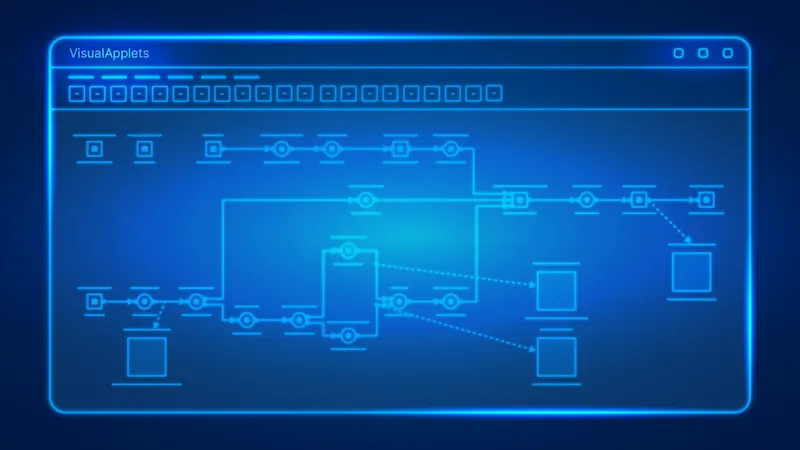

VisualApplets pour la programmation FPGA

Pour les systèmes FPGA, VisualApplets offre un environnement de développement graphique intuitif avec lequel des étapes de prétraitement d'images peuvent être mis en œuvre de manière flexible au niveau matériel. Cette combinaison garantit une flexibilité, une évolutivité et une précision maximales dans l'ensemble du système de vision par apprentissage profond. Le prétraitement basé sur FPGA permet, par exemple, de réduire et de préparer de manière ciblée de grandes quantités de données avant l'inférence proprement dite, en sélectionnant uniquement les zones d'image pertinentes (région d'intérêt, ROI) pour un traitement ultérieur.

Avantages : réduction de la charge de calcul, débit d'inférence plus élevé avec le même matériel et précision accrue en se concentrant sur l'essentiel.

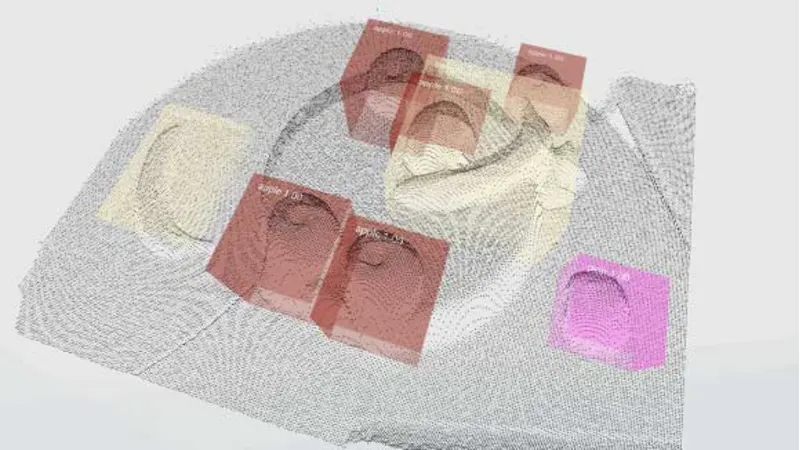

Inférence à travers le modèle d'IA

Au cours de la phase d'inférence, un réseau neuronal convolutif (CNN) prend généralement en charge l'analyse des données d'image entrantes. Le modèle traite les images capturées par la caméra de vision industrielle en plusieurs couches successives afin d'extraire les caractéristiques pertinentes telles que les formes, les bords ou les textures. Il s'ensuit une classification, une segmentation ou une reconnaissance d'objet, en fonction de la tâche à accomplir.

Avec pylon AI et les pylon vTools, ce processus est automatisé et en temps réel : les données d'image sont directement transférées au modèle d'IA, qui identifie alors les composants défectueux, lit le texte sur les produits (OCR), ou localise des objets spécifiques dans l'image, par exemple.

Les résultats de l'inférence sont immédiatement disponibles pour les processus en aval tels que le tri, le contrôle de la qualité ou l'optimisation des processus. L'intégration transparente dans le système de vision en deep learning garantit une prise de décision rapide, précise et reproductible.

La qualité du modèle dépend en grande partie de la qualité des données d'entraînement et de l'optimisation du matériel utilisé. La qualité d'image la plus élevée possible n'est donc pas seulement importante dans l'étape du processus d'acquisition d'images - elle constitue la base de l'entraînement de l'IA. Plus la qualité de ces données d'image est élevée au cours de la formation, plus les résultats des analyses de l'IA et les décisions qui en découlent seront précis et fiables.

Les modèles qui ont déjà été pré-entraînés peuvent être facilement intégrés et développés avec pylon AI.

Intégration des systèmes et interfaces

Décisif pour la performance des systèmes de vision en deep learning

La mise en œuvre réussie de systèmes de vision à apprentissage profond dans le traitement industriel des images dépend dans une large mesure d'une intégration bien pensée du système et du choix des bonnes interfaces. Une communication efficace entre le modèle d'IA et le matériel ainsi qu'une intégration harmonieuse dans le processus de production sont ici d'une importance capitale.

Communication transparente entre le matériel et les logiciels

Le logiciel pylon fournit des pilotes certifiés et des interfaces puissantes qui garantissent une communication directe et fiable entre l'inférence de l'IA et le matériel de la caméra. Il s'agit notamment de normes telles que GigE Vision pour des solutions réseau flexibles, USB3 Vision pour une connectivité simple et CoaXPress pour des applications avec les exigences les plus élevées en matière de bande passante et de temps réel. Ces interfaces standardisées minimisent l'effort d'intégration et garantissent une transmission stable des données.

pylon AI offre ici une solution puissante en permettant l'intégration de réseaux neuronaux convolutifs (CNN) directement dans le pipeline de traitement d'images établi de pylon. Cela garantit un traitement robuste et efficace des données.

Connectivité industrielle

La prise en charge de OPC UA est essentielle pour la connexion à des systèmes de contrôle de niveau supérieur. Elle permet le transfert direct des résultats de l'IA vers les systèmes PLC ou MES. En tant que norme indépendante de la plateforme et du fabricant, OPC UA garantit un échange de données simple et normalisé entre les machines. Avec le OPC UA vTool, vous pouvez publier les résultats du pipeline de traitement d'images directement sur un serveur OPC UA pour un échange de données transparent.

Un générateur de codes de recettes peut également faciliter l'adaptation rapide des modèles d'IA à l'évolution des variantes de produits et accroître ainsi la flexibilité de la production. Des informations détaillées sur le générateur de code de recette dans le visualiseur pylon sont également disponibles dans la documentation produit de Basler.

Architectures flexibles : intégration de l'informatique en périphérie et de l'informatique en nuage

Les exigences des systèmes de vision en deep learning varient considérablement en fonction de l'application. Il est donc essentiel de disposer d'architectures flexibles :

L'informatique en périphérie pour les applications décentralisées

Pour les applications critiques en termes de latence, mobiles ou décentralisées, la technologie de vision embedded offre la possibilité d'exécuter des modèles d'IA directement à la périphérie". Les plateformes telles que NVIDIA® Jetson™ permettent aux modèles d'IA de s'exécuter instantanément sur l'appareil, garantissant une autonomie maximale, une latence minimale et une dépendance réduite aux connexions réseau."

Intégration dans le nuage pour l'évolutivité

Pour les applications qui nécessitent de grandes quantités de données, un entraînement distribué ou une gestion centralisée de nombreux systèmes, nous prenons en charge l'intégration avec les principales plateformes cloud telles que Amazon Web Services (AWS), Microsoft Azure et Google Cloud Platform. Cela permet d'obtenir l'évolutivité et la flexibilité nécessaires pour les flux de travail complexes de deep learning.

Cette intégration de systèmes normalisés et flexibles garantit une analyse rapide, fiable et reproductible des données d'image. Elle permet l'intégration de systèmes de vision à apprentissage profond dans des environnements de production distribués, de sorte que les analyses et les décisions assistées par l'IA sont prises directement là où les données d'image sont générées. Cela est crucial pour un contrôle de qualité efficace, la détection des erreurs et l'optimisation des processus dans des réseaux de production complexes et multi-sites.

Une installation simple et une intégration fiable du système sont essentielles pour une réussite à long terme et permettent de maîtriser efficacement des tâches complexes.

Un système de vision à apprentissage profond fonctionnel se compose, par exemple, d'une caméra de vision artificielle de haute qualité, d'une carte d'acquisition d'images puissante, d'un matériel de traitement d'images adapté, d'un logiciel d'apprentissage profond spécialisé et d'un modèle d'IA optimisé. Des interfaces fiables et performantes garantissent un processus d'intégration du système sans heurts. Avec nos produits et services, nous offrons aux ingénieurs en vision et à toute personne impliquée dans des solutions d'IA pour leur application une base solide pour des projets de traitement d'images industrielles sophistiqués - du développement de prototypes à la production en série.