Sistemi di visione deep learning per l'elaborazione di immagini industriali

Struttura e componenti del sistema

I sistemi di visione basati sul deep learning sono spesso già una componente centrale dell'elaborazione industriale delle immagini. Consentono un rilevamento preciso degli errori, un controllo intelligente della qualità e decisioni automatizzate, laddove i metodi convenzionali di elaborazione delle immagini raggiungono i loro limiti. Mostriamo com'è strutturato un sistema di visione funzionale con deep learning e quali componenti sono necessari per un funzionamento affidabile.

Ultimo aggiornamento: 02/12/2025

La struttura dei sistemi di visione deep learning

I sistemi di visione deep learning sono progettati da zero per le reti neurali. Si basano sulla potenza di calcolo delle GPU, su framework ottimizzati e su approcci di apprendimento end-to-end. Questo li rende flessibili, ma spesso anche ad alto consumo di risorse.

L'obiettivo: integrazione dell'IA end-to-end, dall'acquisizione delle immagini al processo decisionale

L'obiettivo principale di un sistema di visione deep learning è la perfetta integrazione dell'intelligenza artificiale in tutte le fasi del processo. Dal

acquisizione di dati grezzi da parte della telecamera tramite la

elaborazione in tempo reale dei dati di immagine pensata per un

processo decisionale automatizzato attraverso il modello AI

Tutti i componenti sono ottimizzati per il deep learning. Questo crea un sistema chiuso che fornisce risultati precisi, riproducibili e scalabili per le applicazioni industriali più esigenti.

Pipeline di visione per il deep learning: dall'acquisizione delle immagini al processo decisionale supportato dall'IA

L'interazione dei componenti del sistema è fondamentale per le prestazioni di un sistema di visione deep learning. Il flusso di lavoro tipico di un sistema di visione deep learning si svolge in queste fasi successive:

1. Acquisizione dell'immagine: la telecamera per la visione artificiale acquisisce l'immagine grezza e fornisce dati di immagine di alta qualità.

2. Trasmissione dell'immagine: Un frame grabber trasmette i dati dell'immagine in modo efficiente e senza perdite all'hardware di elaborazione.

3. Pre-elaborazione: il software del pilone o le funzioni interne della fotocamera ottimizzano l'immagine (ad esempio, riduzione del rumore o debayering). Il software di deep learning si occupa del controllo, della configurazione e dell'analisi dei dati utilizzando modelli AI.

4. Inferenza AI: il modello CNN analizza l'immagine e prende una decisione (ad esempio, il rilevamento di un errore).

5. Trasmissione dei risultati: i risultati vengono inoltrati al controllore o al sistema di livello superiore.

Le interfacce e le soluzioni di integrazione assicurano una comunicazione fluida tra i moduli e consentono l'integrazione negli ambienti di produzione esistenti. Questo processo garantisce un'analisi delle immagini rapida, affidabile e riproducibile nelle applicazioni industriali.

I componenti hardware e software di un sistema di visione deep learning

Un sistema di visione deep learning è costituito da diversi componenti tecnicamente coordinati. Ogni componente svolge un compito specifico all'interno del sistema complessivo e contribuisce alle sue prestazioni e alla sua affidabilità.

Hardware di visione per il deep learning

L'hardware di elaborazione delle immagini è il centro dati del sistema di visione deep learning. La scelta dell'hardware dipende dai requisiti in termini di velocità di elaborazione, costi di sistema e scalabilità. A seconda dell'applicazione, si utilizzano piattaforme diverse:

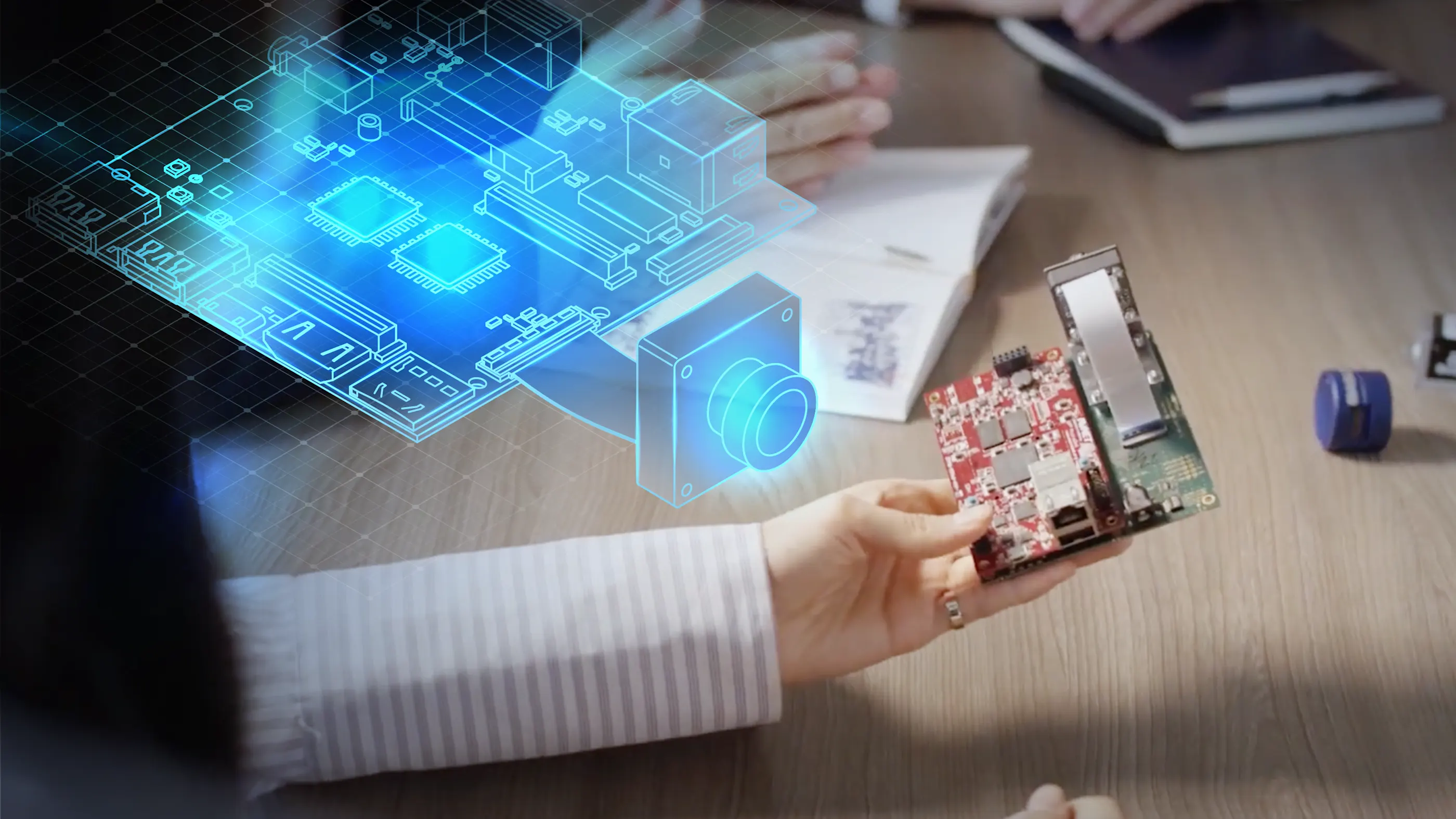

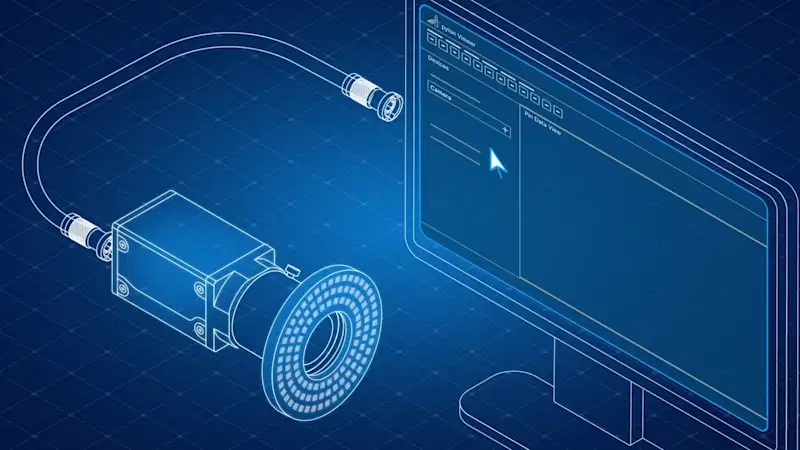

Telecamera per la visione artificiale

La telecamera di visione artificiale è il cuore del sistema. Cattura i dati delle immagini che vengono successivamente elaborati dal modello di intelligenza artificiale. Le telecamere industriali come Basler ace, Basler ace 2, Basler dart o Basler racer series offrono:

Alta risoluzione e qualità dell'immagine

Supporto per interfacce comuni come GigE, USB 3.0 e CoaXPress

Pre-elaborazione interna dell'immagine (ad es. de-bayering, nitidezza, riduzione del rumore)

Risultati riproducibili per applicazioni di deep learning affidabili

Frame grabber e gestione dei dati di immagine

Un frame grabber è indispensabile per le applicazioni con elevata velocità di trasmissione dei dati o tempo reale. I frame grabber acquisiscono i dati dell'immagine direttamente dalla telecamera e li trasmettono al sistema per l'ulteriore elaborazione. Soprattutto in combinazione con i processori FPGA, consentono un'acquisizione e un'elaborazione delle immagini ad alta velocità, senza latenze e robusta.

Software e strumenti per il deep learning

Il software costituisce il collegamento tra l'hardware e il modello di intelligenza artificiale. Consente l'integrazione, la configurazione e il controllo delle telecamere, nonché l'addestramento e l'esecuzione dei modelli di apprendimento profondo.

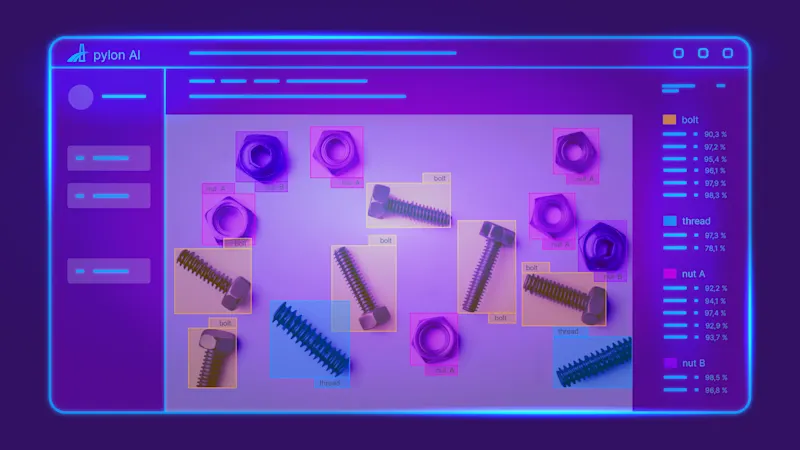

pylon AI

Con pylon AI, è disponibile una potente piattaforma sviluppata appositamente per l'integrazione e l'esecuzione efficiente delle reti neurali convoluzionali (CNN) nei flussi di lavoro di elaborazione delle immagini industriali. pylon AI consente la semplice integrazione, l'ottimizzazione e il benchmarking dei propri modelli AI direttamente sull'hardware di destinazione.

pylon vTools per l'elaborazione delle immagini

La combinazione con i vTools pylon offre funzioni di elaborazione delle immagini pronte all'uso e specifiche per le applicazioni, come il riconoscimento di oggetti, l'OCR, la segmentazione e la classificazione, senza conoscenze approfondite di programmazione. I vTools si basano su algoritmi classici e intelligenza artificiale.

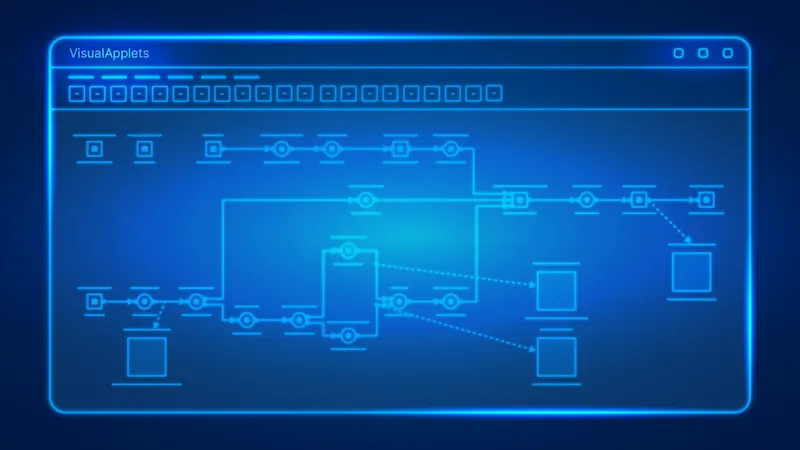

VisualApplets per la programmazione di FPGA

Per i sistemi basati su FPGA, VisualApplets offre un ambiente di sviluppo grafico e intuitivo con il quale è possibile implementare in modo flessibile a livello hardware fasi di pre-elaborazione delle immagini. Questa combinazione garantisce la massima flessibilità, scalabilità e precisione del sistema di visione per il deep learning. La pre-elaborazione basata su FPGA consente, ad esempio, di ridurre grandi quantità di dati e prepararli in modo mirato prima dell'effettiva inferenza, selezionando solo le aree dell'immagine rilevanti (regione di interesse, ROI) per l'ulteriore elaborazione.

Vantaggi: riduzione del carico di calcolo, maggiore velocità di inferenza con lo stesso hardware e maggiore precisione grazie alla focalizzazione sugli elementi essenziali.

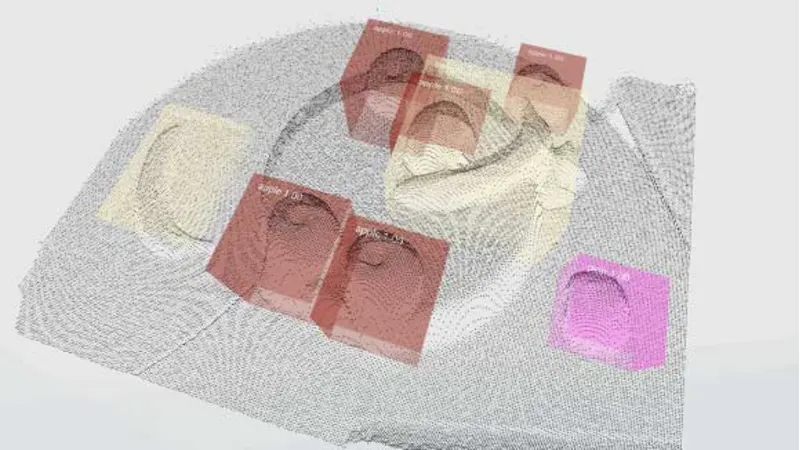

Inferenza attraverso il modello AI

Durante la fase di inferenza, una CNN (rete neurale convoluzionale) si occupa solitamente dell'analisi dei dati delle immagini in arrivo. Il modello elabora le immagini catturate dalla telecamera di visione artificiale in diversi livelli successivi, al fine di estrarre caratteristiche rilevanti come forme, bordi o texture. Segue la classificazione, la segmentazione o il riconoscimento degli oggetti, a seconda del compito da svolgere.

Con pylon AI e pylon vTools, questo processo è automatizzato e in tempo reale: i dati dell'immagine vengono trasferiti direttamente al modello AI, che quindi identifica i componenti difettosi, legge il testo sui prodotti (OCR) o localizza oggetti specifici nell'immagine, ad esempio.

I risultati dell'inferenza sono immediatamente disponibili per i processi a valle, come lo smistamento, il controllo qualità o l'ottimizzazione dei processi. La perfetta integrazione nel sistema di visione deep learning garantisce un processo decisionale rapido, preciso e riproducibile.

La qualità del modello dipende in larga misura dalla qualità dei dati di formazione e dall'ottimizzazione dell'hardware utilizzato. La massima qualità possibile delle immagini non è quindi importante solo nella fase di acquisizione delle immagini, ma costituisce la base per l'addestramento dell'IA. Più alta è la qualità dei dati di immagine durante l'addestramento, più precisi e affidabili saranno i risultati delle analisi dell'IA e le decisioni che ne derivano.

I modelli già preaddestrati possono essere facilmente integrati e sviluppati con pylon AI.

Integrazione del sistema e interfacce

Decisivo per le prestazioni dei sistemi di visione deep learning

Il successo dell'implementazione di sistemi di visione deep learning nell'elaborazione industriale delle immagini dipende in larga misura da un'integrazione ben ponderata del sistema e dalla scelta delle interfacce giuste. Una comunicazione efficiente tra il modello di intelligenza artificiale e l'hardware e un'integrazione senza problemi nel processo di produzione sono di fondamentale importanza.

Comunicazione hardware-software senza soluzione di continuità

Il software pylon fornisce driver certificati e potenti interfacce che garantiscono una comunicazione diretta e affidabile tra l'inferenza AI e l'hardware della telecamera. Queste includono standard come GigE Vision per soluzioni di rete flessibili, USB3 Vision per una connettività semplice e CoaXPress per applicazioni con i più alti requisiti di larghezza di banda e tempo reale. Queste interfacce standardizzate riducono al minimo lo sforzo di integrazione e garantiscono una trasmissione stabile dei dati.

pylon AI offre una soluzione potente, consentendo l'integrazione delle reti neurali convoluzionali (CNN) direttamente nella pipeline di elaborazione delle immagini di pylon. Ciò garantisce un'elaborazione dei dati robusta ed efficiente.

Connettività industriale

Il supporto per OPC UA è essenziale per il collegamento a sistemi di controllo di livello superiore. Consente di trasferire direttamente i risultati dell'IA ai sistemi PLC o MES. Come standard indipendente dalla piattaforma e dal produttore, OPC UA garantisce uno scambio di dati semplice e standardizzato tra le macchine. Con il vTool OPC UA, è possibile pubblicare i risultati della pipeline di elaborazione delle immagini direttamente su un server OPC UA per uno scambio di dati senza soluzione di continuità.

Un Generatore di codice ricetta può anche facilitare il rapido adattamento dei modelli AI alle varianti di prodotto in evoluzione, aumentando così la flessibilità della produzione. Informazioni dettagliate sul generatore di codice ricetta nel visualizzatore di piloni sono disponibili nella documentazione del prodotto Basler.

Architetture flessibili: edge computing e integrazione del cloud

I requisiti dei sistemi di visione deep learning variano notevolmente a seconda dell'applicazione. Per questo motivo è essenziale disporre di architetture flessibili:

Edge computing per applicazioni decentralizzate

Per le applicazioni critiche in termini di latenza, mobili o decentralizzate, la tecnologia di visione embedded offre la possibilità di eseguire modelli di IA direttamente sull'edge". Piattaforme come NVIDIA® Jetson™ consentono ai modelli di intelligenza artificiale di essere eseguiti istantaneamente sul dispositivo, garantendo la massima autonomia, una latenza minima e una ridotta dipendenza dalle connessioni di rete."

Integrazione con il cloud per la scalabilità

Per le applicazioni che richiedono grandi quantità di dati, formazione distribuita o gestione centralizzata di molti sistemi, supportiamo l'integrazione con le principali piattaforme cloud come Amazon Web Services (AWS), Microsoft Azure e Google Cloud Platform. Questo garantisce la scalabilità e la flessibilità necessarie per i complessi flussi di lavoro di deep learning.

Questa integrazione di sistemi standardizzata e flessibile garantisce un'analisi rapida, affidabile e riproducibile dei dati di immagine. Consente di integrare i sistemi di visione deep learning in ambienti di produzione distribuiti, in modo che le analisi e le decisioni supportate dall'intelligenza artificiale vengano prese direttamente dove vengono generati i dati delle immagini. Questo è fondamentale per un controllo qualità efficiente, per il rilevamento degli errori e per l'ottimizzazione dei processi in reti di produzione complesse e multi-sito.

L'installazione semplice e l'integrazione affidabile del sistema sono essenziali per il successo a lungo termine e aiutano a gestire in modo efficiente compiti complessi.

Un sistema di visione funzionale per il deep learning è composto, ad esempio, da una telecamera per la visione artificiale di alta qualità, un potente frame grabber, un hardware di elaborazione delle immagini adeguato, un software di apprendimento profondo specializzato e un modello di intelligenza artificiale ottimizzato. Interfacce affidabili e ad alte prestazioni garantiscono un processo di integrazione del sistema senza problemi. Con i nostri prodotti e servizi, offriamo agli ingegneri della visione e a chiunque sia coinvolto in soluzioni di IA per le loro applicazioni una solida base per sofisticati progetti di elaborazione delle immagini industriali, dallo sviluppo di prototipi alla produzione in serie.